ทดสอบรอบนี้ยังเหมือนเดิม Google Assistant ตอบได้มากสุด เข้าใจทุกคำถาม

Loup Ventures บริษัทลงทุนในด้านการวิจัยได้จัดการทดสอบวัดความสามารถของผู้ช่วยอัจฉริยะ 4 รายได้แก่ Google Assistant, Siri, Alexa และ Cortana ซึ่ง Google Assistant ก็ยังคงสามารถตอบคำถามได้มากที่สุดและเข้าใจทุกคำถามได้เหมือนเดิม ไม่แตกต่างจากการทดสอบเมื่อกลางปี

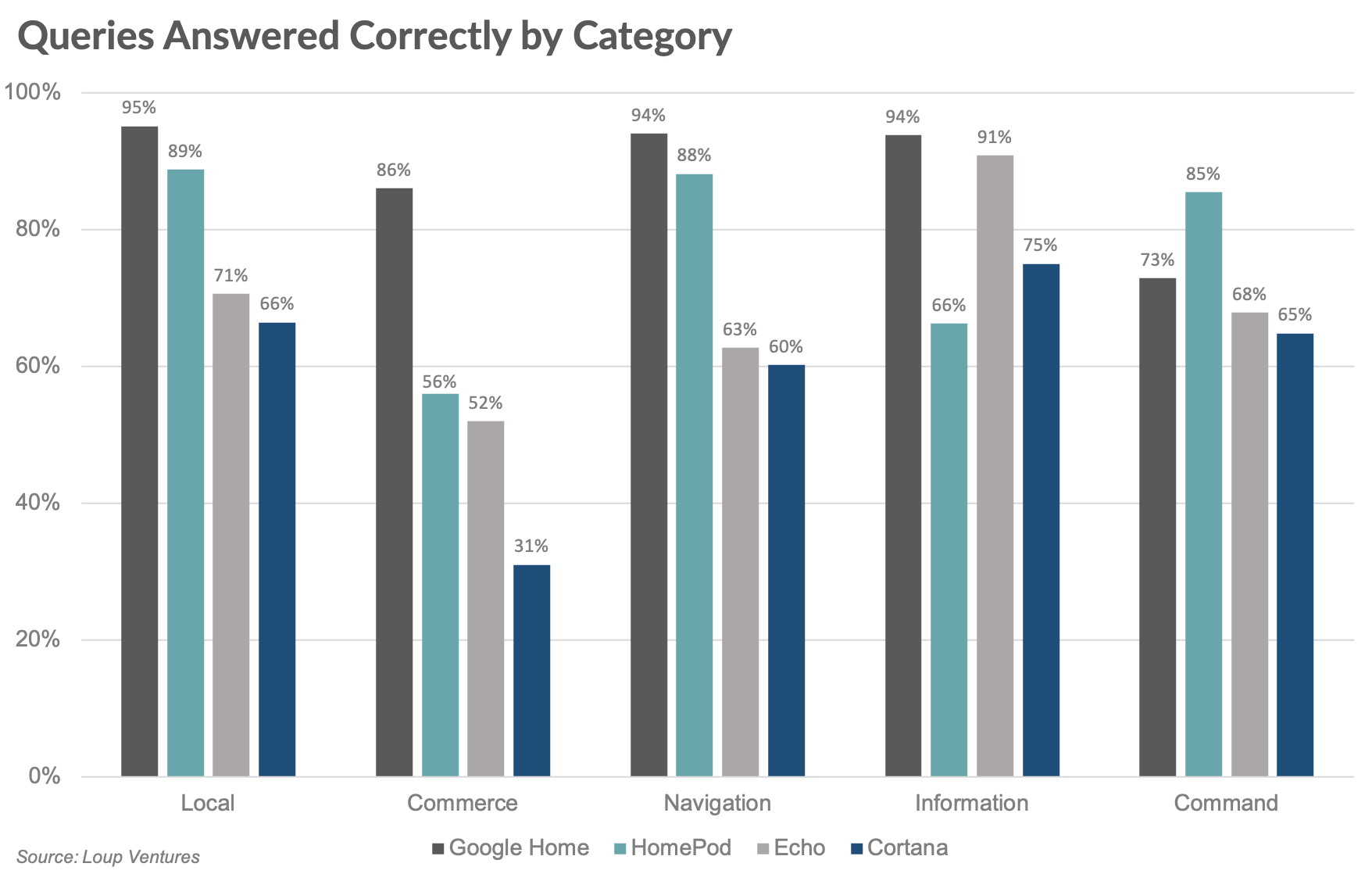

ระเบียบวิธีทดสอบยังคงเหมือนเดิมคือ ถามคำถาม/คำสั่งทั้งหมด 800 ชุดแก่ผู้ช่วยอัจฉริยะแต่ละตัว แบ่งเป็น 5 หมวดหมู่ได้แก่ ข้อมูลในท้องที่ต่างๆ (Local), สั่งของออนไลน์ (Commerce), นำทาง (Navigation), ข้อมูลทั่วไป (Information) และคำสั่ง (Command) โดยรอบนี้ฮาร์ดแวร์ต่างๆ ทั้งลำโพงที่ใช้สั่งงาน รวมถึงสมาร์ทดีไวซ์ต่างๆ ในบ้านก็หลากหลายมากขึ้น

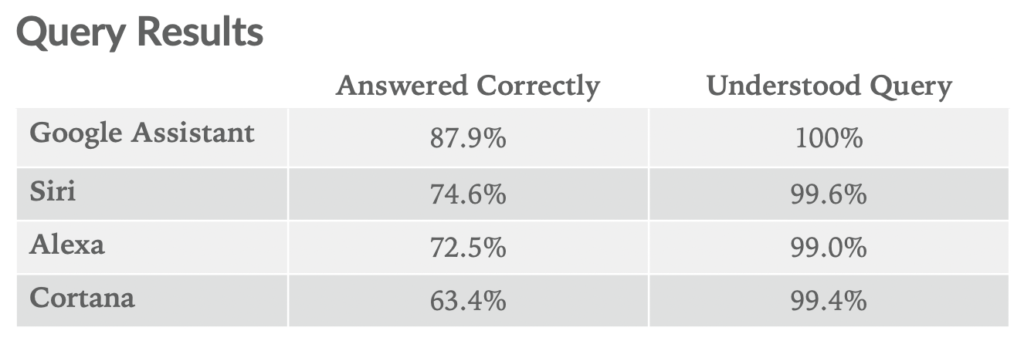

ผลคือ Google Assistant ตอบคำถาม/คำสั่งได้ 88% (รอบก่อน 85.5%) และเข้าใจคำถามทั้งหมด 100% ส่วน Siri ตอบได้ 74.6% (รอบก่อน 78.5%) ไม่เข้าใจ 3 คำถาม, Alexa ตอบได้ 73% (รอบก่อน 61.4%) ไม่เข้าใจ 8 คำถามและ Cortana ตอบได้ 63% (รอบก่อน 52.4%) ไม่เข้าใจ 5 คำถาม

Loup Ventures สรุปเหมือนเดิมว่าสิ่งที่ทำให้ AI เหล่านี้ไม่เข้าใจคำถามคือชื่อเฉพาะ ไม่ว่าจะชื่อร้านอาหาร ชื่อถนนหรือชื่อเมือง หากไม่นับเรื่องนี้ก็แทบจะเข้าใจที่เราสื่อสารได้ทั้งหมดเลยก็ว่าได้

เมื่อแยกเป็นหมวดๆ Google Assistant ยังคงมีคะแนนนำทั้ง 4 หมวดเหมือนเดิมคือข้อมูลท้องที่ (Local), สั่งของออนไลน์ (Commerce), นำทาง (Navigation), ข้อมูลทั่วไป (Information) ส่วนคำสัง (Command) ยังเป็น Siri เช่นเดิมด้วยเหตุผลว่า Siri ทำงานร่วมกับแอปต่างๆ ในระบบนิเวศน์ตัวเองได้เป็นอย่างนี้ อย่างอีเมลและส่งข้อความ

ที่มา - Loup Ventures