MLPerf ออกผลทดสอบความเร็วคอมพิวเตอร์ฝึก AI: NVIDIA โชว์ฝึก GPT3 ในเวลาไม่ถึง 4 นาที, กูเกิลเปิดตัว TPU v5e

MLCommons เปิดผลทดสอบ MLPerf 3.1 การทดสอลคอมพิวเตอร์ฝึกปัญญาประดิษฐ์โดยช่วงหลังความสนใจไปอยู่ที่การฝึกโมเดลภาษาขนาดใหญ่ (large language model - LLM) รอบนี้ NVIDIA ยังคงสามารถโชว์เครื่องที่ฝึกได้เร็วที่สุด จากบริษัทที่ส่งผลทดสอบเข้าร่วม 3 รายหลัก คือ NVIDIA, Intel, และ Google

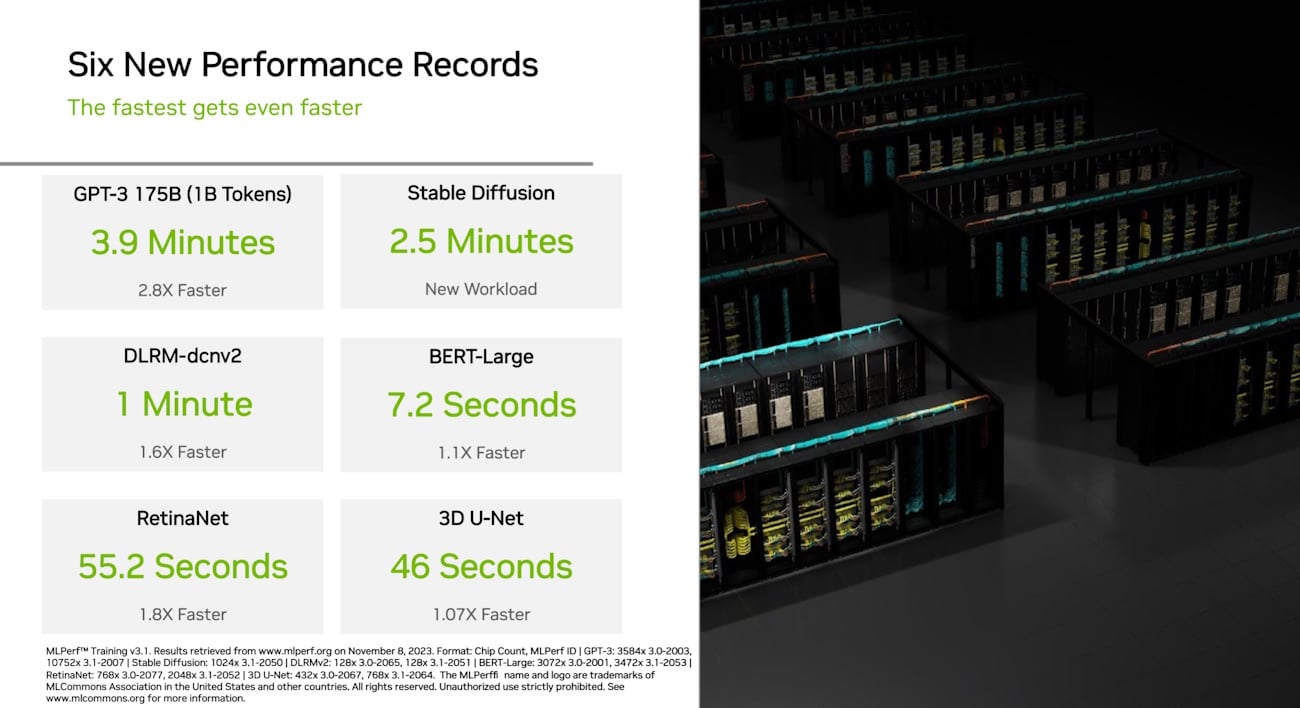

NVIDIA อาศัยเครื่อง NVIDIA Eos ภายในมีชิป NVIDIA H100 ทั้งหมด 10,752 ใบ จำนวนมากกว่าเครื่องเดิมที่เคยส่งผลทดสอบ 3 เท่าตัว เวลาฝึก GPT3 เหลือเพียง 3.9 นาทีเท่านั้น และยังได้พลังประมวลผลเพิ่มขึ้น 2.8 เท่า คิดเป็นประสิทธิภาพการสเกลเครื่อง 93%

ความพิเศษของรอบนี้คือ Azure ส่งผลทดสอบเครื่องแบบเดียวกันด้วย โดยใช้เครื่องขนาดเท่ากัน ปรากฎว่า Azure ND มีประสิทธิภาพช้ากว่าเครื่องของ NVIDIA เพียง 2% เท่านั้นแสดงให้เห็นว่าเครื่องขนาดนี้เช่าใช้ได้จริงในคลาวด์

ทางฝั่ง Google ส่ง TPU v5e โดยโชว์การประมวลผลแบบ INT8 ที่อาศัยเทคนิค quantize แบบแม่นยำสูง แม้จะใช้เวลาฝึก GPT3 นาน 44.68 นาทีบนเครื่อง TPU v5e ขนาด 4,096 ชิป แต่กูเกิลก็โชว์ว่าประสิทธิภาพต่อราคาของ TPU v5e นั้นดีกว่ามาก ค่าเช่าใช้งานอยู่ที่ 1.2 ดอลลาร์ต่อชิปต่อชั่วโมงเท่านั้น ในการประกาศผลทดสอบนี้ Google ก็ประกาศบริการเช่าชิป TPU v5e เป็นสถานะ GA

ทางด้านอินเทลยังคงส่งผลโดยใช้ชิป Intel Gaudi2 แต่สามารถเร่งความเร็วขึ้นได้ด้วยการฝึกโมเดลแบบ FP8 แทน โดยใช้เวลาฝึก GPT3 รวมเวลา 153.58 นาทีบนเครื่องที่มีชิป Gaudi2 จำนวน 384 ชิป ความได้เปรียบของ Gaudi2 อยู่ที่ราคาต่อประสิทธิภาพประหยัดกว่า และสามารถซื้อไปใช้งานในองค์กรได้

ที่มา - MLCommons, NVIDIA, Google, Intel