ไมโครซอฟท์ออกโมเดลภาษาขนาดเล็ก Phi-2 คุยว่าชนะโมเดลขนาดใหญ่ Llama 2 70B

ไมโครซอฟท์ปล่อยโมเดลภาษาขนาดเล็ก (small language model หรือ SLM) ชื่อ Phi-2 ขนาด 2.7 พันล้านพารามิเตอร์ ให้ลูกค้าใช้งานบน Azure AI Studio

Phi-2 เป็นผลงานพัฒนาของทีม Machine Learning Foundations ภายใต้ Microsoft Research ตัวมันเองเป็นโมเดลแบบ Transformer เทรนบนข้อมูลขนาด 1.4T token บนเครื่อง NVIDIA A100 GPU จำนวน 96 ตัว ใช้เวลาเทรน 14 วัน ถือเป็นโมเดลที่สร้างโดยคนของไมโครซอฟท์เอง ไม่ต้องพึ่งพาฝั่ง OpenAI

ไมโครซอฟท์เปิดตัว Phi-2 ครั้งแรกในงาน Ignite เมื่อเดือนที่แล้ว จุดเด่นของมันคือเป็นโมเดลขนาด 2.7B ที่มีประสิทธิภาพใกล้เคียงหรือเหนือกว่าโมเดลขนาดที่ใหญ่กว่ามัน 25 เท่า

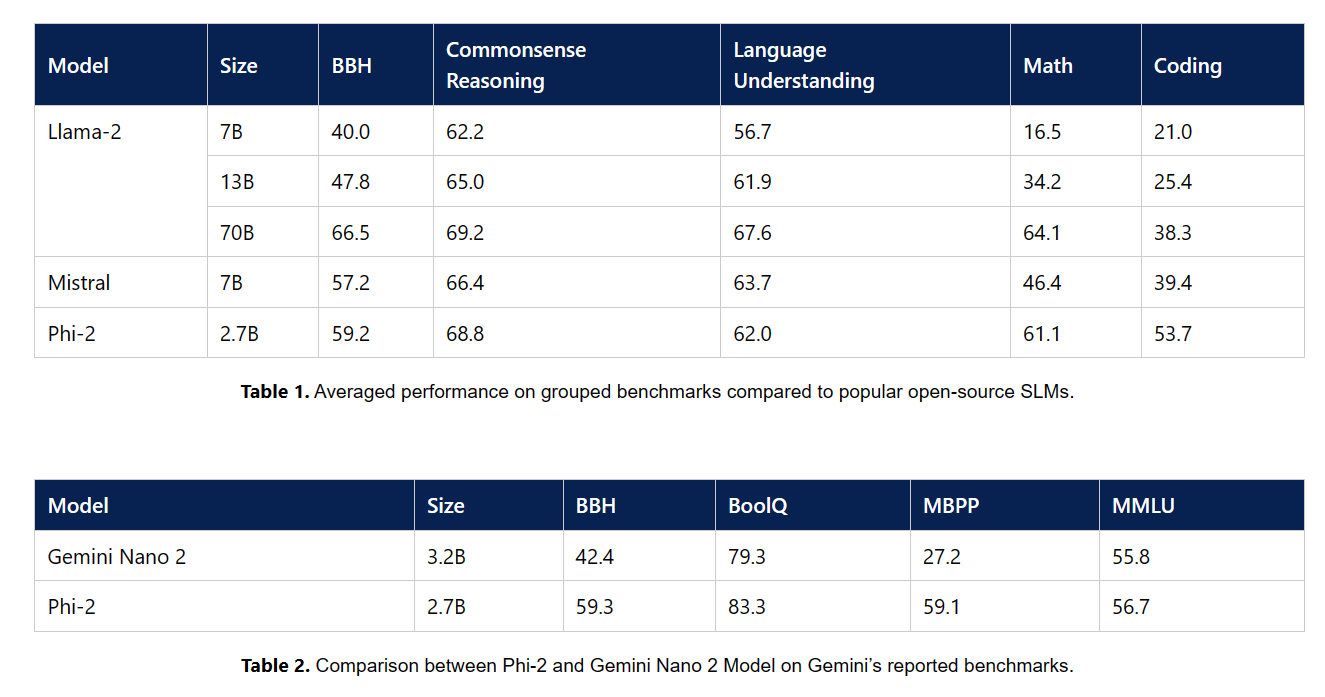

ไมโครซอฟท์ลองวัดผล Phi-2 กับเบนช์มาร์คยอดนิยมในโลก AI จำนวน 7 หมวด Big Bench Hard (BBH) (3 shot with CoT), commonsense reasoning (PIQA, WinoGrande, ARC easy and challenge, SIQA), language understanding (HellaSwag, OpenBookQA, MMLU (5-shot), SQuADv2 (2-shot), BoolQ), math (GSM8k (8 shot)), coding (HumanEval, MBPP (3-shot))

ผลออกมาว่า Phi-2 สามารถเอาชนะโมเดลที่ใหญ่กว่าได้ ทั้ง Mistral-7B, Llama-2-13B หรือแม้กระทั่ง Llama-2-70B ที่ขนาดใหญ่กว่ากันมาก คะแนนเบนช์มาร์คของ Phi-2 ยังเอาชนะโมเดลขนาดเล็กที่เพิ่งออกอย่าง Google Gemini Nano 2 ขนาด 3.2B ด้วย

ที่มา - Microsoft