นักวิจัยเปิดตัว Nightshade ฝังลายน้ำลงภาพ เป็นการวางยาพิษให้โมเดล AI ทำงานผิดเพี้ยน

ปีที่แล้วเรามีข่าว ทีมนักวิจัยจาก University of Chicago ออกแอพชื่อ Glaze ป้องกันไม่ให้ AI นำภาพไปลอกสไตล์งานวาด ปีนี้ทีมนักวิจัยชุดเดิมออกเครื่องมือตัวใหม่ชื่อ Nightshade เปรียบเสมือน "การวางยาพิษ" ให้โมเดล AI ทำงานเพี้ยนไปแทน (ตั้งชื่อตามดอกไม้พิษ Nightshade)

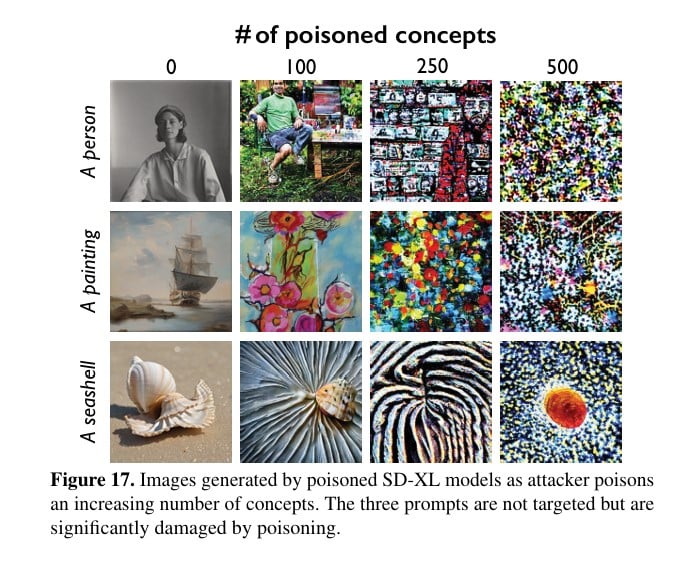

ทีมนักวิจัยเปรียบเทียบ Glaze ว่าเป็นมาตรการ "ป้องกัน" ส่วน Nightshade เป็นมาตรการ "โจมตี" โดยเทคนิคของ Nightshade คือการแทรกโค้ดที่มนุษย์มองไม่เห็นลงไปในภาพ แต่ AI จะมองเห็นภาพนั้นผิดเพี้ยนไปจากเดิม เมื่อนำภาพที่ฝัง Nightshade ไปเทรนโมเดล จะทำให้ผลลัพธ์ออกมาไม่เสถียรเหมือนเดิม

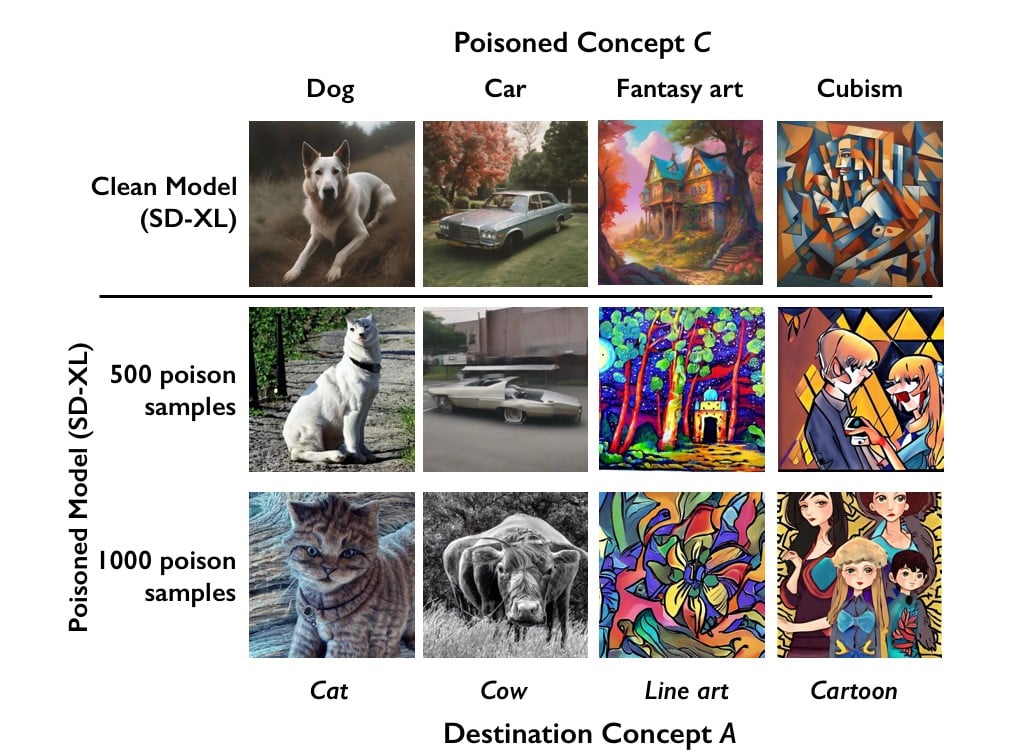

ในเปเปอร์วิจัยที่ตีพิมพ์ในเดือนตุลาคม 2023 โชว์ตัวอย่างโมเดลที่ถูก "วางยา" ว่าโมเดลที่สั่งสร้างภาพหมา หากรับภาพอินพุตที่ถูกวางยาไปครบ 1,000 ตัวอย่าง จะได้ภาพออกมาเป็นแมวแทน จะเห็นว่าโมเดลยังทำงานไม่ผิดเพี้ยนมากนักเมื่อรับอินพุตที่ถูกวางยาไป 500 ตัวอย่าง แต่เมื่อโดนวางยาไปครบ 1,000 ตัวอย่างแล้วจะเริ่มออกอาการ

ทีมวิจัยบอกว่า Nightshade ออกแบบให้เป็นอาวุธโต้กลับฝ่ายนักเทรนโมเดล ที่ไม่เคารพทรัพย์สินทางปัญญา หรือไม่ปฏิบัติตามข้อกำหนดต่างๆ (เช่น ที่ระบุไว้ใน robots.txt ว่าห้ามดูดภาพไปเทรน) โดยทีมวิจัยแนะนำว่าควรใช้ Glaze ป้องกันภาพทุกภาพที่เรามี ส่วนจะใช้ Nightshade ต่อสู้กลับด้วยหรือไม่ก็เป็นทางเลือกของศิลปินแต่ละคน และทีมวิจัยกำลังสร้างเครื่องมือที่ใส่ทั้ง Glaze/Nightshade ได้พร้อมกันทีเดียว

ที่มา - Nightshade