ทำคลิปง่ายกว่าเดิม - Google เปิดตัวงานวิจัยสร้างคลิปสั้น โดยใช้ 1 ภาพนิ่ง และไฟล์เสียงพูด

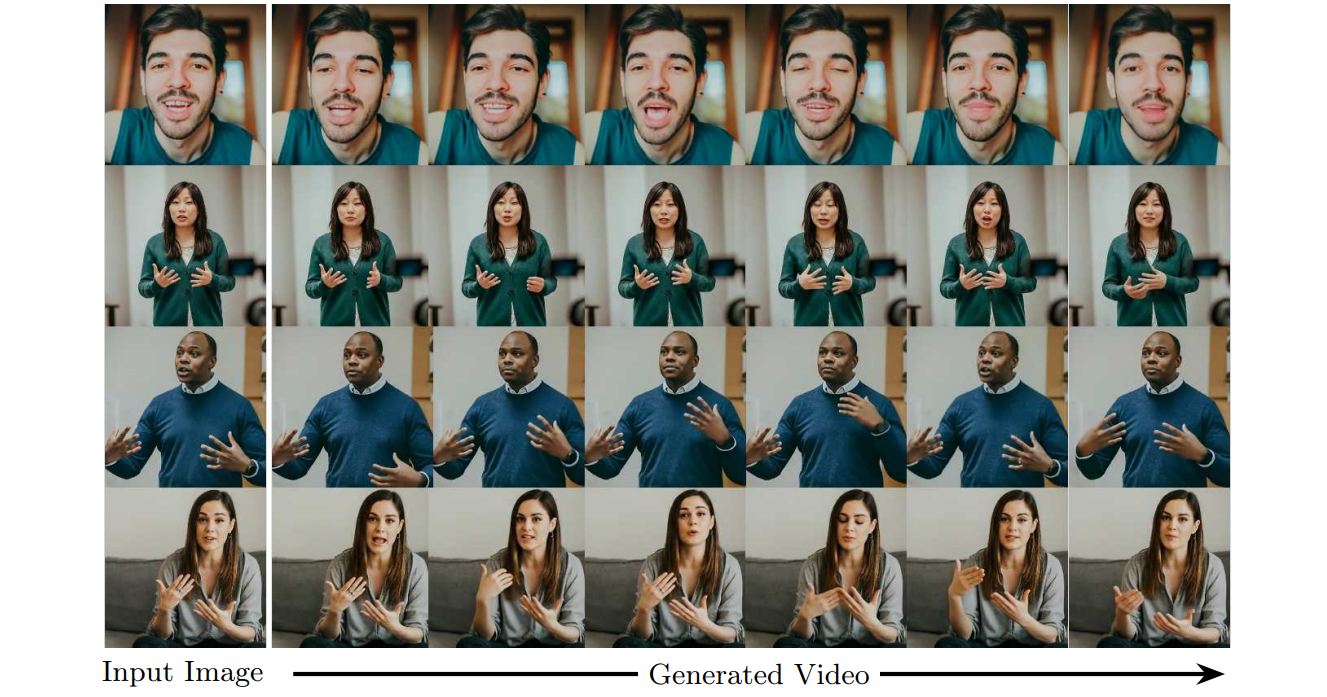

Google Research เผยแพร่งานวิจัยหัวข้อ "VLOGGER: Multimodal Diffusion for Embodied Avatar Synthesis" เป็นโมเดล AI ที่ใช้อินพุทภาพบุคคล 1 ภาพ และไฟล์เสียง สามารถสร้างวิดีโอที่ขยับได้ตามเสียงทั้งปาก ใบหน้า ศีรษะ ตลอดจนมือ

โมเดลนี้มีจุดเด่นคือไม่ต้องอาศัยการเทรนข้อมูลบุคคลนั้นมาก่อน ไม่ต้องระบุตำแหน่งใบหน้าและส่วนต่าง ๆ ก็สามารถสร้างการเคลื่อนไหวในทุกจุดในภาพ โมเดลนี้จึงมีโอกาสนำไปต่อยอดใช้ในการนำเสนอผลงาน งานประกอบการสอน หรืองานที่เดิมมีข้อมูลเฉพาะตัวหนังสือ ให้เป็นภาพเคลื่อนไหวได้ดีขึ้น อย่างไรก็ตามมีความเสี่ยงในการนำไปใช้งานอย่างไม่เหมาะสมด้วยเช่นกัน

VLOGGER ยังมีข้อจำกัดบางอย่าง เช่น ไม่สามารถสร้างวิดีโอขนาดยาวได้, ฉากหลังต้องไม่มีการขยับ ทำให้วิดีโอผลลัพธ์ยังสามารถสังเกตได้ว่าสร้างจาก AI สามารถอ่านรายละเอียดงานวิจัยได้ที่นี่

ที่มา: VentureBeat