MIT วิจัยการถอดเสียงพูดจากคลิปวิดีโอแสดงภาพวัตถุ

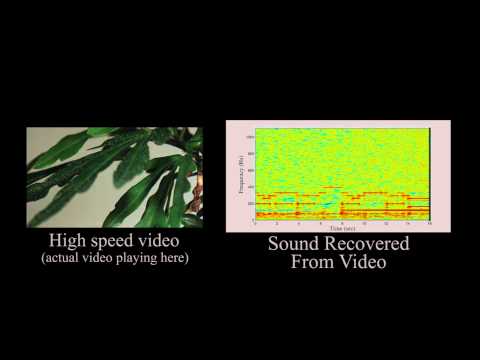

แม้ข่าวนี้จะมาช้าไปหน่อย (ราว 2 สัปดาห์) แต่ก็ถือว่าควรค่าแก่การติดตาม กับผลงานการวิจัยจาก MIT เกี่ยวกับเทคนิคที่เรียกว่า Visual Microphone ซึ่งสามารถถอดรหัสเสียงจากคลิปวิดีโอที่ถ่ายภาพวัตถุในบริเวณที่มีเสียงนั้น

เราคงพอรู้จักเทคนิคการอ่านปากจากในหนังหรือตามข่าวต่างๆ ถึงความสามารถในการเข้าใจคำพูดของบุคคลได้โดยพิจารณาจากลักษณะริมฝีปากของผู้พูด และนั่นทำให้เรารู้ได้ว่าเขากำลังพูดว่าอะไรแม้ว่าในความจริงแล้วเราจะไม่ได้ยินเสียงพูดนั้น แต่ผลงานวิจัยของ MIT นั้นล้ำไปกว่านั้น เพราะอัลกอริธึมของงานวิจัยนี้สามารถรู้ถึงเสียงพูดได้โดยการวิเคราะห์การสั่นไหวของวัตถุซึ่งอยู่ในสถานที่นั้น

หนึ่งในการสาธิตผลงานวิจัยคือการติดตั้งกล้องถ่ายภาพความเร็วสูงไว้ภายนอก โดยกล้องดังกล่าวจับภาพถุงมันฝรั่งที่วางอยู่บนพื้นภายในห้อง ระหว่างกล้องและมันฝรั่งนั้นมีกระจกกันเสียงคั่นกลางไว้อยู่ ด้วยสภาพนี้กล้องถ่ายวิดีโอดังกล่าวจะไม่สามารถได้ยินเสียงในห้องได้เลย จากนั้นจึงให้คนพูดข้อความสั้นๆ ภายในห้อง ซึ่งคลื่นเสียงนั้นมีผลทำให้ถุงมันฝรั่งเกิดการสั่นสะเทือน และเมื่อนำภาพจากกล้องวิดีโอไปประมวลผล ก็สามารถถอดรหัสเสียงพูดได้โดยอาศัยจากการตรวจจับการสั่นสะเทือนของถุงมันฝรั่งในคลิปนั่นเอง

แม้คุณภาพของเสียงที่ถอดมาได้นั้นจะมิได้ชัดเจนเท่าเสียงจริงในเหตุการณ์จริง แต่มันก็เพียงพอที่จะทำให้เข้าใจถ้อยคำพูดของคนที่อยู่ในห้องได้ หรือในอีกตัวอย่างหนึ่ง ผลการถอดรหัสเสียงที่ได้เป็นเสียงเพลงที่ไม่เพียงมนุษย์จะรับรู้ได้ทันทีว่าคือเพลงอะไร แต่กระทั่งซอฟต์แวร์ค้นหาเพลงออนไลน์ก็ยังสามารถหาเพลงที่สัมพันธ์กับผลการถอดรหัสนั้นได้ถูกต้องเช่นกัน

ในด้านหนึ่งงานวิจัยนี้ชวนให้นึกถึงการพัฒนาเทคนิคการจารกรรมข้อมูล หรือการลอบดักฟัง แต่การใช้งานจริงยังคงมีข้อจำกัดจากปัจจัยภายนอกอีกหลายประการ เพราะการที่จะใช้อัลกอริธิม Visual Microphone นี้ได้ จำเป็นต้องมีการถ่ายภาพด้วยกล้องความเร็วสูง ทั้งยังต้องควบคุมให้กล้องและวัตถุที่ถูกถ่ายวิดีโอนิ่งให้มากที่สุด ซึ่งยังคงยากที่จะทำได้จริงในบริเวณทั่วไปนอกพื้นที่วิจัย

ที่มา - The Next Web